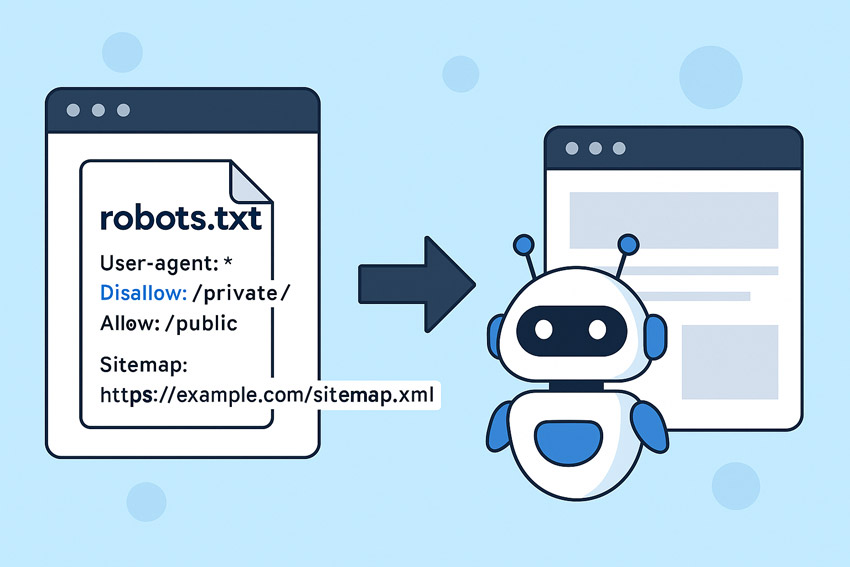

Файл robots.txt — це текстовий файл, який розміщується в кореневій директорії сайту і містить інструкції для пошукових роботів щодо того, які сторінки можна або не можна індексувати. Це важливий інструмент технічної SEO-оптимізації.

Для чого потрібен файл robots.txt

Основні завдання цього файлу:

- Заборонити індексацію технічних або службових сторінок (наприклад, /admin, /cart, /wp-login.php);

- Уникнути дублювання контенту;

- Оптимізувати час обходу сайту роботами (Crawl Budget);

- Вказати шлях до карти сайту (sitemap.xml).

Як створити файл robots.txt

Це звичайний текстовий файл, який має назву robots.txt і розміщується за адресою https://ваш-домен.com/robots.txt. Його можна створити у звичайному текстовому редакторі або за допомогою SEO-плагіна (наприклад, Yoast SEO).

Приклад правильного robots.txt

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-login.php

Allow: /wp-admin/admin-ajax.php

Sitemap: https://ваш-домен.com/sitemap.xml

Пояснення основних директив

- User-agent — визначає, до якого робота застосовуються правила (символ * — до всіх роботів);

- Disallow — забороняє доступ до зазначених сторінок або директорій;

- Allow — дозволяє доступ до певних сторінок (актуально для Googlebot);

- Sitemap — вказує пошуковим системам розташування файлу sitemap.xml.

Часті помилки при складанні robots.txt

- Повна заборона для всіх сторінок сайту (

Disallow: /); - Відсутність дозволу для важливих скриптів (наприклад, AJAX);

- Неправильне розміщення файлу — не в корені сайту;

- Відсутність вказівки на sitemap.xml.

Як перевірити файл robots.txt

Скористайтесь інструментом «robots.txt Tester» у Google Search Console або сторонніми сервісами на кшталт Screaming Frog, Ahrefs, Sitechecker тощо.

Висновок

Правильно складений файл robots.txt — це важливий елемент оптимізації сайту для пошукових систем. Він допомагає контролювати індексацію, захищає службові сторінки від показу у видачі й оптимізує ресурси сканування. Обов’язково перевіряйте його після кожної зміни структури сайту або переїзду.